当强化学习真正走向规模化:环境才是被低估的主角

这场演讲并不只是谈如何“把RL环境做大”,而是重新定义了环境在强化学习中的角色:它既是研究瓶颈,也是打开人才与创新速度的钥匙。Will Brown分享了他对RL规模化的独特视角,以及为什么“环境设计”正在成为下一阶段的核心竞争力。

这场演讲并不只是谈如何“把RL环境做大”,而是重新定义了环境在强化学习中的角色:它既是研究瓶颈,也是打开人才与创新速度的钥匙。Will Brown分享了他对RL规模化的独特视角,以及为什么“环境设计”正在成为下一阶段的核心竞争力。

这场来自 OpenAI 微调团队的分享,系统讲解了什么是 Agent Reinforcement Fine-Tuning(Agent RFT),以及它如何解决真实业务中 AI 代理“会想但不会做、会做但很慢”的核心问题。通过多个一线客户案例,演讲者展示了 Agent RFT 在工具调用、延迟控制和少样本学习上的独特价值。

Harvey 联合创始人兼总裁 Gabe Pereyra 在 No Priors 访谈中,系统讲述了 AI 如何从“律师 Copilot”进化为重塑法律组织的核心基础设施。这不仅是效率工具的故事,更是关于企业级治理、Agent 工作流和法律行业未来结构的深度思考。

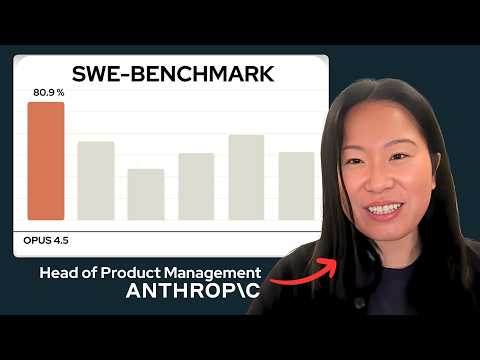

这期《AI Daily Brief》揭示了一个被忽视却至关重要的转折点:在Gemini 3与Claude Opus 4.5的压力下,OpenAI似乎终于修复了预训练瓶颈,而Anthropic则在产品、收入和资本市场三线并进。大模型竞争,正在从“调参和包装”回到真正的基础能力比拼。

Anthropic 首位产品经理 Diane 在访谈中系统讲述了 Opus 4.5 背后的产品与研究逻辑:模型能力如何规划、脚手架为何正在变成“智能放大器”,以及为什么安全不是成本而是竞争壁垒。这篇文章提炼了视频中最具启发性的判断与真实案例。

在这期访谈中,DeepMind研究员谭捷系统讲述了他如何从计算机图形学与强化学习出发,走到通用机器人研究前沿。他分享了机器人为何长期缺乏“常识”、数据墙如何限制进展,以及Gemini Robotics 1.5试图用世界模型和Thinking能力打开新局面的真实思路。

在Gemini 3发布前夕,杰夫·贝索斯高调回归CEO岗位,亲自下场打造一家名为Project Prometheus的AI公司。与外界想象不同,这不是又一家大模型创业公司,而是一场瞄准制造、工程和物理世界的AI豪赌。与此同时,xAI的Grok 4.1更新也揭示了AI竞争的新方向。

这期《The AI Daily Brief》用一个前所未有的真实案例,宣告了“Agent Hacker时代”的到来:AI代理不再只是辅助工具,而是可以在极少人类干预下,完成大规模网络攻击。视频同时串联了Anthropic的基础设施豪赌、DeepMind的通用代理突破,以及AI创业估值泡沫背后的逻辑。

如果你还觉得把Agent做强=加数据、加算力,这场Build Hour会让你改观。OpenAI用一次完整演示说明:真正拉开Agent差距的,不是预训练,而是Agent Reinforcement Fine-Tuning,以及一整套围绕它的新评估方式。

这期《The AI Daily Brief》通过四个看似分散的新闻,勾勒出一个更大的趋势:AI并没有简单地“抢走”既有市场,而是在资本结构、企业治理、内容生产和模型能力边界上不断扩张新空间。从软银豪赌OpenAI,到企业级AI治理,再到游戏产业与“会学习的模型”,我们正在进入一个全新的AI阶段。