通用人工智能的真实挑战:我们究竟在“规模化”什么?

当前AI领域对通用人工智能(AGI)的期待与现实之间存在显著张力。本文深入探讨了强化学习、大语言模型与持续学习的局限性,分析了为何模型尚未实现人类般的泛化与经济价值,并展望了未来AI发展的关键突破点。

当前AI领域对通用人工智能(AGI)的期待与现实之间存在显著张力。本文深入探讨了强化学习、大语言模型与持续学习的局限性,分析了为何模型尚未实现人类般的泛化与经济价值,并展望了未来AI发展的关键突破点。

如果你还以为生成式 AI 只是“帮你快一点”,那这场 Figma CEO Dylan Field 的演示可能会直接颠覆你。Gemini 3 Pro 在 Figma Make 里做的,不是加速设计,而是主动探索、给出意想不到的创意路径——甚至反过来启发人类。

Jerry Liu在这场演讲中直言不讳地指出:当前大量AI Agent并没有真正自动化知识工作。他结合LlamaIndex的实践经验,系统拆解了知识型Agent的真实难点——非结构化数据、工具调用和端到端行动,并给出了一套更务实的构建方法论。

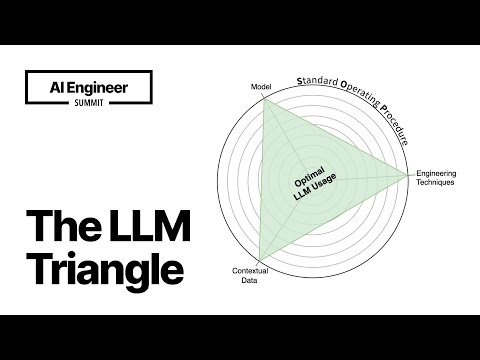

这场演讲并不是在教你“怎么调Prompt”,而是试图回答一个更难的问题:为什么90%的LLM应用死在生产环境。Almog Baku用工程师和创业者的视角,提出了“LLM三角”方法论——模型、工程技术、数据,在SOP的约束下协同工作,才可能构建稳定、可复现的AI应用。

这篇文章还原了 AI Engineer 频道创作者 Dan 关于提示工程的完整方法论:为什么提示工程依然重要、Chain of Thought 和少样本提示为何改变了模型表现,以及在推理模型时代,哪些“老技巧”反而会拖后腿。读完你将知道,问题不在模型,而在你如何与它对话。

在 OpenAI DevDay 的一个不起眼角落,Dimagi 分享了一个让很多 AI 从业者意外的结论:想把大模型用好在低资源语言上,最聪明的做法,可能不是“直接教模型说当地话”。他们用 GPT-4o mini 做机器翻译微调,把 Sheng 这种混合俚语的翻译 BLEU 分数从 22 拉到 65,成本却只要十分之一。

在 OpenAI 首届开发者大会上,一场看似“基础”的分享却抛出了一个让无数团队踩坑的真相:微调不是万能钥匙,甚至常常是最后一步。这场45分钟的技术演讲,实际上给出了一个极其清醒、反直觉的 LLM 性能优化路线图。

你以为只有图片模型才会被“对抗样本”骗?这场 OpenAI Scholars Demo Day 的演讲给了 NLP 社区当头一棒:只要在输入里悄悄塞进一句看似无关、甚至毫无意义的文本,就可能稳定地把语言模型带偏,而且还能跨模型迁移。

如果你不告诉模型什么是力、速度和动量,它还能理解世界吗?在 OpenAI Scholars Demo Day 上,Ifu Aniemeka 用一个看似“幼稚”的实验给出了惊人答案:只靠观察,神经网络真的能学会预测物体运动。这不是炫技,而是世界模型的一次重要试探。

这是一场关于学习、技术判断与现实落地的深度对话。吴恩达回顾了自己从早年接触神经网络、推动MOOC浪潮,到反思深度学习路径选择的关键经验,系统阐述了他对AI教育、技术趋势与产业应用的长期思考。