GPT‑5.4刚发布24小时:最强代码模型,还是被高估的工具怪兽

GPT‑5.4上线不到一天,评论区已经吵翻天:有人说它是“目前最强模型”,也有人开始吐槽它的UI和命名混乱。这支视频最狠的地方不在于跑分,而是点破了一个趋势——大模型正在从“聊天玩具”转向真正的知识工作引擎。

GPT‑5.4上线不到一天,评论区已经吵翻天:有人说它是“目前最强模型”,也有人开始吐槽它的UI和命名混乱。这支视频最狠的地方不在于跑分,而是点破了一个趋势——大模型正在从“聊天玩具”转向真正的知识工作引擎。

如果你还觉得AI只是技术问题,这周的事件会让你彻底清醒:Anthropic被美国政府点名“封杀”,OpenAI却转身签下五角大楼合同。AI不再只是模型优劣之争,而是正式卷入政治、军方与文化战争的中心。

很多人在 X 上刚刚宣布“再也不用 Cursor”,Bloomberg 却丢出一颗炸弹:它的年经常性收入三个月从 10 亿翻到 20 亿。与此同时,Claude 因为用户涌入直接宕机,五角大楼的 AI 合同风波把整个行业拖进政治漩涡。这不是几条新闻,而是一条清晰的信号线。

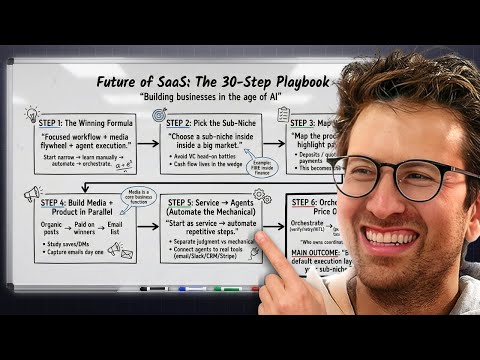

当所有人都在唱衰SaaS时,Greg Isenberg却说:现在是历史上做SaaS最便宜、也最容易赚钱的时代。不是靠一个天才点子,而是一套可复制的30步方法论——AI、Agent、内容和现金流,正在被重新组合。

当David Ellison掏出1110亿美元收购媒体资产、而Larry Ellison被形容为“AGI-pilled”,这期节目抛出的不是八卦,而是一整套科技—媒体—AI正在重新合流的信号。从好莱坞到云计算,再到通用人工智能,这条线正在被重新画出来。

当别人还在把AI当聊天工具时,有人已经决定“住进Cloud Code”。在这期40分钟的实操视频里,Peter Yang和嘉宾Carl现场演示:如何把Claude Code直接接入Google Workspace、Slack等真实工作系统,让AI第一次像“同事”而不是“玩具”。

如果连 Anthropic 都开始松动 AI 安全底线,那这个行业到底还剩下什么“刹车”?在这期 TBPN 中,嘉宾们围绕 Anthropic 最新安全政策展开激烈讨论:竞争压力、国防合作、模型越狱、核战争模拟……一连串细节拼在一起,呈现出一个远比“是否重视安全”更复杂的现实。

一边是企业疯狂买 Token、没人要退款,另一边却有 80% 的公司“从 AI 中得不到价值”。TBPN 这期节目把几条看似不相关的新闻串成了一条残酷主线:AI 已经无处不在,但我们可能正在用错方式理解它、投资它,甚至约束它。

一边是明星卖能量饮料、社交媒体彻底失控;另一边是AI公司估值、产品和伦理同时被拷问。这期《Diet TBPN》把看似杂乱的热点拧成了一根线:AI正在改变一切,但没人真的准备好了。

一档看似“信息过载”的科技节目,却在混乱中透露出一个危险而清晰的信号:AI正在改变的不只是产品,而是金融、研究、创作和权力结构本身。Collison兄弟、Bill Gurley、Ben Thompson们的只言片语,拼出了一张2026年AI产业的真实底图。