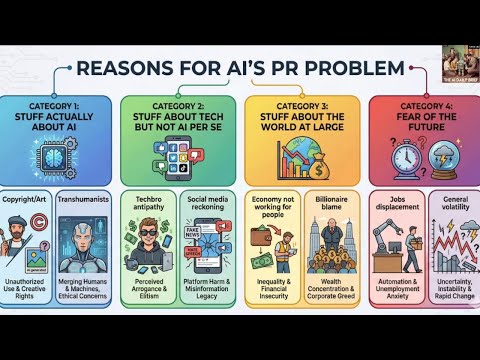

AI为何越强大,公众却越不安?一场正在扩大的信任危机

这期《The AI Daily Brief》提出一个尖锐判断:AI真正的瓶颈不在算力或模型,而在公众信任。通过Edelman与Pew的调查、政治人物的真实反应,以及Satya Nadella的“社会许可”观点,视频揭示了AI被质疑的深层原因,以及可能的破局路径。

这期《The AI Daily Brief》提出一个尖锐判断:AI真正的瓶颈不在算力或模型,而在公众信任。通过Edelman与Pew的调查、政治人物的真实反应,以及Satya Nadella的“社会许可”观点,视频揭示了AI被质疑的深层原因,以及可能的破局路径。

在这场面向早期设计师的 Figma 圆桌里,几位一线从业者几乎达成了一个反直觉共识:真正成熟的 AI 设计能力,不是“会用很多 AI”,而是清楚知道什么时候不用。关于 AI 搜索、语音 AI、Agent 和提示工程,他们讲的不是工具清单,而是一套正在行业内部形成的新判断标准。

当媒体争论“多少工作会被AI取代”时,这期节目把镜头对准了现实:1250位正在使用AI的专业人士,亲口讲述它如何改变他们的工作方式、焦虑与期待。这不是预测,而是一份来自一线的集体经验报告。

这期《AI Daily Brief》把三个看似分散的事件串成了一条清晰主线:资本对AI的焦虑、技术领袖对“AI竞赛”的重新定义,以及AI在真实消费场景中的首次规模化验证。本文将拆解微软AI销售目标调整背后的误读,黄仁勋对AI终局的冷思考,以及黑色星期五中AI Agent交出的成绩单。

Anthropic的哲学家Amanda Askell在访谈中,深入探讨了AI模型Claude的伦理、对齐、身份认同与未来风险。她分享了哲学与工程实践的张力、AI模型“心理”健康、以及AI与人类关系的复杂性,为AI发展提供了独特的思考路径。

一个年收入480万美元、正在高速增长的iOS应用,被两个人用AI在32分钟内“复刻”出来,还顺手接上了真实支付。这不是标题党,而是一次把AI应用、无代码、原生订阅和App Store上架全部打通的完整演示。真正震撼的不是技术,而是门槛的坍塌。

围绕“AI是否已经能替代12%工作”的争议,MIT的Project Iceberg研究与Anthropic内部实践给出了远比标题党复杂的答案。这篇文章拆解11.7%这一数字的真实含义,并结合Anthropic工程师的一线经验,理解AI如何在任务、技能而非岗位层面,悄然重塑工作本身。

Harvey 联合创始人兼总裁 Gabe Pereyra 在 No Priors 访谈中,系统讲述了 AI 如何从“律师 Copilot”进化为重塑法律组织的核心基础设施。这不仅是效率工具的故事,更是关于企业级治理、Agent 工作流和法律行业未来结构的深度思考。

过去十年,设计工具一直在进化,但有个尴尬现实始终没变:原型永远只是原型。Figma Make 的出现,第一次把“一句话”直接变成可交互、可上线、背后还有真实代码的应用。这不只是效率提升,而是设计、工程和 AI 协作方式的一次重写。

493秒,从想法到上架 App Store:有前端、有后端、有数据库、有 AI、还能收钱。这不是黑客炫技,而是一次赤裸裸地展示——AI 已经把“做一个完整应用”的门槛,直接按到了地板上。