MCP 并没有被 Skills 干掉,相反它们一起解决了 AI Agent 最大的坑

很多人以为 Skills 是来取代 MCP 的,但 Ras Mic 在这期视频里给了一个反直觉的答案:真正的问题从来不是工具不够,而是 Agent 根本不会用。这篇文章拆解 MCP 为什么曾经“翻车”,Skills 又是如何把幻觉、混乱和上下文灾难一并收拾干净的。

很多人以为 Skills 是来取代 MCP 的,但 Ras Mic 在这期视频里给了一个反直觉的答案:真正的问题从来不是工具不够,而是 Agent 根本不会用。这篇文章拆解 MCP 为什么曾经“翻车”,Skills 又是如何把幻觉、混乱和上下文灾难一并收拾干净的。

如果你只把这期节目当成一次“财报串烧”,那你就错过了真正的信号:微软、Meta、特斯拉、苹果、OpenAI正在用完全不同的路径,争夺同一件事——AI时代的控制权。这不是短期股价故事,而是一场关于模型、分发、算力与数据的长期博弈。

大多数人把 AI 当工具,他却把 AI 当成“操作系统”。在这期视频里,Greg Isenberg 展示了一种反直觉的用法:不是 App、不是自动化脚本,而是用 Discord + Clawdbot,把生活和公司全天候托管给 AI。

如果你还以为 AI 创作必须靠严密计划和长周期推进,这场 Demo Day 会直接打脸。Every 团队用一周“纯 vibe coding”——几乎不设路线图,只跟着感觉走,却做出了两个直指未来工作方式的 AI 原型。

如果你以为AGI只差算力和数据,那这期播客会让你清醒。前OpenAI研究副总裁Jerry Twerk首次系统谈及离职原因、他眼中真实的AGI时间表,以及一个让很多从业者不安的判断:强化学习和Scaling Laws,正在逼近天花板。

你的网站不转化,可能不是产品不够强,而是你根本没说清楚自己在干嘛。Y Combinator 最新一期视频里,Framer CEO 现场看了多个 AI 创业项目的网站和展示,暴露出一个让人不舒服但极其真实的事实:大多数创业公司,第一屏就已经把用户劝退了。

如果没有AI,我们现在可能已经在为经济崩盘而恐慌——但Marc Andreessen的判断更激进:今天这波AI热潮,连“前菜”都算不上。在这期Lenny播客里,他谈的不只是AGI,而是为什么未来真正吃香的不是“会用AI的人”,而是某一类正在被严重低估的专业角色。

在 GameStop 事件最混乱的时刻,Vlad Tenev 一边要向公众解释复杂到几乎无法讲清的系统风险,一边要在一夜之间筹集数十亿美元。他在红杉资本的这次对谈,揭示了一种反直觉的 CEO 心法:真正的公司,从来就没有“和平时期”。

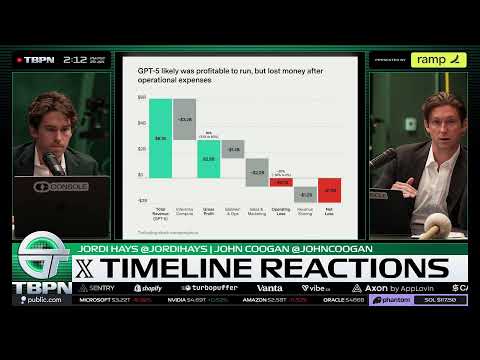

当所有人都在追问“AI会不会毁掉影视创作”时,这期 TBPN 给了一个更刺耳的判断:AI不是Netflix最大的变量,YouTube才是。更反直觉的是,AI反而可能成为Netflix守住高端内容护城河的工具。这是一场关于平台定位、创作权力和注意力再分配的深度对话。

如果你最近觉得“AGI 已经来了”的声音突然变多了,那不是错觉。在这期 TBPN 里,几条看似分散的讨论被一条暗线串了起来:AI 正在加速创造内容、挤压平台、搅动资金,也逼着整个行业重新定义什么才算“有价值的智能”。