当基准走向真实世界:一次AI评测与芯片博弈的年终切片

这期《AI Daily Brief》把视角从“刷榜”的模型基准,拉回到真实世界的工作任务,同时又突然切入中美芯片博弈与资本市场震荡。它展示了评测方法、算力成本、地缘政治如何在同一时间点交织,塑造AI行业的真实走向。

这期《AI Daily Brief》把视角从“刷榜”的模型基准,拉回到真实世界的工作任务,同时又突然切入中美芯片博弈与资本市场震荡。它展示了评测方法、算力成本、地缘政治如何在同一时间点交织,塑造AI行业的真实走向。

这场演讲并不是一次常规的模型发布,而是一份关于“如何把小模型做成好用Agent”的方法论说明。Olive Song从开发者体验出发,解释了Miniax M2为何以10B参数,却在真实编码与Agent任务中赢得社区认可。

斯坦福对12万名开发者、46对团队的长期研究发现:AI并非“用得越多越好”。真正拉开差距的,是代码库卫生、使用方式,以及是否用正确的指标衡量AI带来的工程产出。

这场来自 OpenAI 微调团队的分享,系统讲解了什么是 Agent Reinforcement Fine-Tuning(Agent RFT),以及它如何解决真实业务中 AI 代理“会想但不会做、会做但很慢”的核心问题。通过多个一线客户案例,演讲者展示了 Agent RFT 在工具调用、延迟控制和少样本学习上的独特价值。

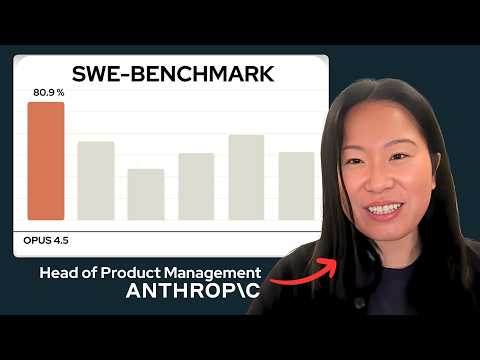

Anthropic 首位产品经理 Diane 在访谈中系统讲述了 Opus 4.5 背后的产品与研究逻辑:模型能力如何规划、脚手架为何正在变成“智能放大器”,以及为什么安全不是成本而是竞争壁垒。这篇文章提炼了视频中最具启发性的判断与真实案例。

三天前,开发者还在吹 Gemini 3 Pro;三天后,很多人已经悄悄换成了 Claude Opus 4.5。不是跑分噱头,而是真实项目、真实代码、真实 PR 的碾压级体验。这篇文章告诉你:为什么 Opus 4.5 会成为很多人眼里的“唯一主力模型”,以及它真正该怎么用。

这期《The AI Daily Brief》详细拆解了Claude Opus 4.5的真实能力边界:它不仅在多项Agent基准上刷新纪录,更重要的是把“能持续工作的AI代理”从几分钟拉长到半小时,为Vibe Coding和未来工作方式提供了现实范本。

如果你还把设计系统当成“组件库+文档”,这场 Figma 的演讲会让你彻底坐不住。Figma 在 2025 年抛出一个反直觉观点:设计系统的真正用户,正在从设计师,变成 AI。本篇文章带你拆解这背后的逻辑、工具变化,以及它对 AI 从业者意味着什么。

当所有人都在把AI往设计流程里塞时,LinkedIn的设计系统团队却在Figma现场抛出一个反直觉结论:真正的危机不是“不会用AI”,而是“人人都能用AI”之后,设计如何不失控。这场分享,讲清了设计系统在生成式AI时代为什么必须彻底变形。

当所有人都在谈生成式 AI、对话式界面和无限 UI 时,Figma Config 2025 的这场演讲抛出了一个反直觉的观点:真正伟大的设计系统,从诞生那天起就是为“无限”准备的,AI 只是让这件事暴露得更彻底。