一个99%都是机器人的社交网络,正在逼AI圈重新审视LLM时代

一个几乎全是机器人的“社交网络”突然刷屏科技圈。TBPN 在这期节目里抛出的不是新产品,而是一个更刺眼的问题:当 bots 成为主要用户,LLM 生态、产品边界和失控风险该如何重画?

一个几乎全是机器人的“社交网络”突然刷屏科技圈。TBPN 在这期节目里抛出的不是新产品,而是一个更刺眼的问题:当 bots 成为主要用户,LLM 生态、产品边界和失控风险该如何重画?

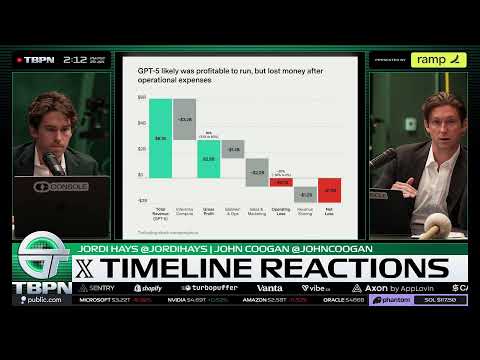

当所有人都在谈“全自动 AI Agent”“全球持久化智能体”时,TBPN 这期节目却泼了一盆冷水:真实体验并不惊艳,甚至有点失望。从 Moltbook 的奇怪写作风格,到 LLM 世界里的 prompt injection 野蛮生长,再到 Nvidia 与 OpenAI 的资本暗线,这是一期明显“降温”的内容。

GPT‑5.2 开始解数学难题,但真正震撼科学界的不是模型本身,而是 OpenAI 做了一件更“脏活累活”的事:把 AI 直接嵌进科学家的日常工作流。Prism 的出现,可能比一次模型升级更接近“科学加速器”的本质。

当所有人都在问“AI是不是泡沫”时,资本市场给出了一个反直觉答案:不是一起涨或一起跌,而是彻底分化。Meta在不计成本押注AI后股价大涨,而微软却因为基础设施跟不上被市场冷落。这背后,隐藏着2026年AI竞争真正的生死线。

如果你还在纠结“哪个大模型会赢到最后”,这期 Lex Fridman 的对话可能会直接颠覆你的默认认知。在 Sebastian Raschka 和 Nathan Lambert 看来,2026 年的 AI 竞争,赢家不是某一个模型,而是一整套新的玩法:开源与闭源并存、速度与智能取舍、后训练比架构更重要,以及一个被低估的关键词——“多模型时代”。

OpenAI 首次 Town Hall 没有发布新模型,却信息量爆炸:Sam Altman 当众承认 GPT-5 写作“搞砸了”,明确招聘将放缓,同时抛出一个更激进的判断——两年内,更高水平的智能会以 100 倍更低成本到来。这场看似平淡的 Q&A,其实暴露了 OpenAI 的真实焦虑与路线选择。

大多数人以为这只是一场 FigJam 的新功能演示,但真正炸裂的点在于:Figma 和 Anthropic 正在用 MCP 把 AI 从“只会回文本”,推进到“直接参与团队协作”。这场 Live Demo,几乎把 AI 在产品、工程和日常决策中的下一种形态提前演给你看。

如果你只把这期节目当成一次“财报串烧”,那你就错过了真正的信号:微软、Meta、特斯拉、苹果、OpenAI正在用完全不同的路径,争夺同一件事——AI时代的控制权。这不是短期股价故事,而是一场关于模型、分发、算力与数据的长期博弈。

如果你最近刷过 AI Twitter,却发现自己完全听不懂 Ralph、Claudebot、Vibe Coding 在说什么,这不是你的问题——而是行业真的换挡了。这期 AI Daily Brief 透露了一个信号:2026 年,专业程序员的核心能力,正在从“写代码”变成“组织 AI 写代码”。

Sam Altman 说过一句被很多人当成“疯话”的预测:未来会出现“一个人做到十亿美元估值”的公司。这条视频里,Greg Isenberg 直接把这件事摊开来给你看——不是概念,而是一套正在运行的 AI Agent 系统,已经隐约露出那种公司的雏形。