从提示到多智能体:LinkedIn构建GenAI平台的真实路径

LinkedIn并非一开始就要打造宏大的GenAI平台,而是在真实产品压力下,一步步演化出支撑AI Agent的基础设施。本文还原Xiaofeng Wang的分享,讲清楚他们为何自建平台、如何从简单Prompt走向多智能体系统,以及这些选择背后的工程与组织洞见。

LinkedIn并非一开始就要打造宏大的GenAI平台,而是在真实产品压力下,一步步演化出支撑AI Agent的基础设施。本文还原Xiaofeng Wang的分享,讲清楚他们为何自建平台、如何从简单Prompt走向多智能体系统,以及这些选择背后的工程与组织洞见。

RAG(检索增强生成)的提出者Douwe Kiela,用真实的企业落地经验解释了一个残酷现实:AI投入巨大,但真正产生价值的公司不到四分之一。这篇文章提炼了他在生产环境中踩过的坑、反直觉的认知,以及为什么“系统”和“上下文”才是AI ROI的决定因素。

Meta发布Llama 4并抛出“1000万Token上下文窗口”的震撼指标,但真实影响远比参数更复杂。本文还原视频中的关键讨论,解释为什么这一突破既可能改变工作流,也可能只是被过度营销的技术噱头。

在这场来自AI Engineer Summit的演讲中,Neo4j的Stephen Chin与辉瑞的Jonathan Lowe直面一个残酷现实:大量生成式AI项目正在走向失败。通过一个真实的生物制药案例,他们展示了如何用知识图谱和Graph RAG,把“炫技的AI”变成真正能落地、能拯救生命的企业级系统。

当大多数公司直接接入现成AI工具时,Jane Street却选择了一条更难的路:围绕自研语言生态,从数据、训练到编辑器,重新打造AI开发工具链。这篇文章还原了他们如何在“模型不懂OCaml”的现实下,把大语言模型真正变成可用生产力。

在这场看似轻松却信息密度极高的演讲中,swyx给出了一个清晰信号:AI工程正在从“调用模型”迈向“构建Agent”。这不仅是技术能力成熟的结果,更是一场关于身份、方法论和产业方向的转变。

Patrick Dougherty在创业过程中推翻整套产品,转而用AI Agent重构系统。这次分享不是概念宣讲,而是来自真实生产环境的教训:什么才算Agent、为什么“会想”比“知道多”更重要,以及哪些常见做法其实在拖垮Agent表现。

这篇文章还原了Cohere工程师Shaan Desai关于“企业级LLM Agent如何真正跑起来”的一线经验,从框架选择、单/多Agent策略,到安全、评估与失败治理,揭示了为什么大多数Agent原型很炫却难以规模化,以及Cohere如何把这些教训固化成产品North。

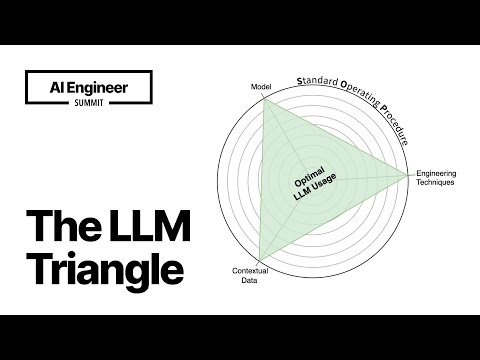

这场演讲并不是在教你“怎么调Prompt”,而是试图回答一个更难的问题:为什么90%的LLM应用死在生产环境。Almog Baku用工程师和创业者的视角,提出了“LLM三角”方法论——模型、工程技术、数据,在SOP的约束下协同工作,才可能构建稳定、可复现的AI应用。

在Agentic AI成为主流的2025年,真正的难题已不再是模型能力,而是如何让AI系统变得可预测、可审计、可控制。AI Engineer频道的Adam Charlson提出,将有限状态机与Actor模型、LLM结合,或许是一条被低估但极其务实的路径。